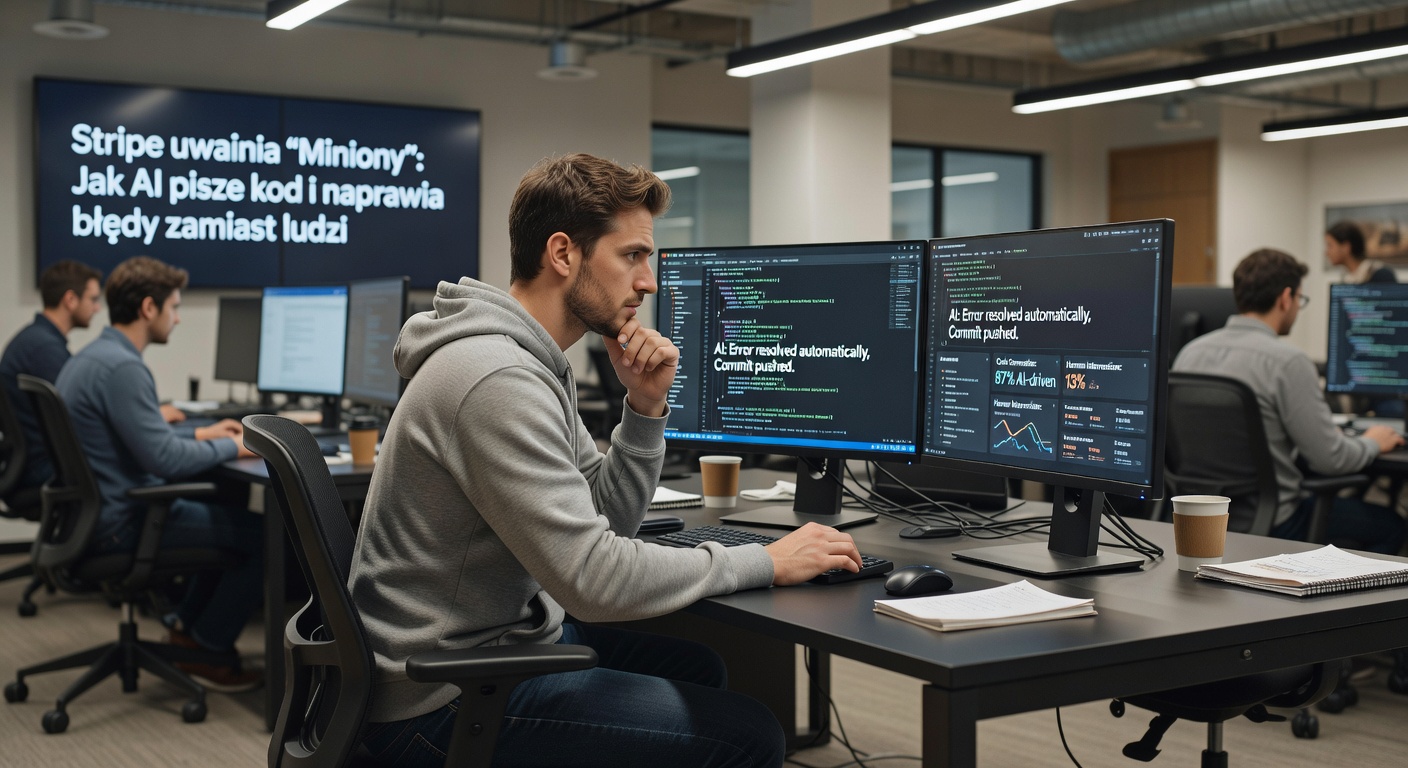

Dax Raad nie jest typowym krytykiem sztucznej inteligencji. Jako współzałożyciel projektu opencode.ai i firmy anoma.ly zajmuje się AI zawodowo. Jego obserwacje z pierwszej linii frontu wdrożeniowego odbiły się szerokim echem w społeczności technologicznej.

Na platformie X podzielił się niewygodną diagnozą obecnej sytuacji w wielu firmach. Według niego panuje iluzja, że jedynym ograniczeniem rozwoju jest tempo pisania kodu. AI miałoby to magicznie przyspieszyć.

Ale prawda jest bardziej skomplikowana. A często po prostu przygnębiająca.

Kod jak śmietnik

Raad wskazał na fundamentalny problem. Firmy rzadko kiedy mają naprawdę dobre pomysły, a dawniej skrupulatna selekcja pomagała wprowadzać tylko to, co faktycznie potrzebne.

Teraz każdy może szybko wygenerować mnóstwo kodu za pomocą AI. I robi to.

W swoich wypowiedziach Raad argumentował, że używanie AI nie wiąże się z dziesięciokrotnym wzrostem efektywności. Jego zdaniem, pracownicy chcą po prostu szybciej "odbębnić swoje" i wyjść do domu.

Efekt? Lawina średniej jakości lub po prostu złego kodu, który zalewa projekty. Prawdziwym kosztem tego procesu nie są licencje na narzędzia AI.

Najlepsi sprzątają bałagan

Presja spada na wąską grupę najbardziej zaangażowanych programistów. To oni muszą później porządkować ten chaos, poprawiać błędy i utrzymywać systemy zbudowane na kiepskich fundamentach.

To ich frustruje i szybciej wypala. W dłuższej perspektywie mogą po prostu odejść z firmy, zabierając ze sobą bezcenne doświadczenie i wiedzę o systemie.

Raad dotknął też sedna problemu wielu organizacji. Prawdziwym ograniczeniem często nie jest technologia czy kodowanie, ale przerośnięta biurokracja, złe procesy decyzyjne i słaba komunikacja między działami.

AI tego nie naprawi. Może tylko przyspieszyć wprowadzanie złych decyzji.

W swojej krytyce wskazywał, że finalnie firmy zostają z dyrektorem ds. finansowych zastanawiającym się, dlaczego każdy inżynier kosztuje więcej, mimo braku wzrostu efektywności pracy.

Programiści potwierdzają: to nasza codzienność

Reakcja w sieci była natychmiastowa i pełna uznania dla trafności obserwacji. Wielu programistów rozpoznało własne doświadczenia w słowach Raada.

Na Reddicie użytkownik jamintimes stwierdził krótko: "Fragment o śmieciowym kodzie brzmi zbyt prawdziwie. Sprzątanie śmietnika po LLM-ach to moja nowa praca na pełen etat".

Inny komentator, Sad-Salt24, dodał głębszą refleksję: "AI nie zmieniła magicznie przeciętnych pomysłów w świetne, tylko ułatwiła wprowadzenie w większej liczbie tego, co już istniało. Jeśli kultura pracy była kiepska, to szybsze wyniki tylko wzmacniają bałagan".

Pojawiły się też głosy o szerszym kontekście pracy programisty. Użytkownik iscottjs opisał sytuację z nietechnicznym menedżerem zachwyconym artykułem o Spotify, gdzie chwalono się wdrażaniem funkcji z poziomu telefonu.

"A ja na to: no tak, a co z całym planowaniem, spotkaniami, testowaniem, architekturą? Z tym całym międzydziałowym syfem?" – pytał retorycznie programista.

Gdzie leży prawdziwy problem?

Obserwacje Raada wpisują się w szersze badania pokazujące brak spektakularnego wzrostu produktywności dzięki AI oraz zwiększone ryzyko wypalenia zawodowego wśród pracowników intensywnie korzystających z tych narzędzi.

Ciekawostka: sama łatwość generowania treści bywa problemem. Kiedy każdy może szybko stworzyć dokumentację, prezentację czy fragment kodu, rośnie ilość materiału do przejrzenia, skoordynowania i utrzymania.

Bez odpowiednich procesów zarządczych i kultury pracy skupionej na jakości a nie tylko szybkości, korporacje mogą faktycznie płacić więcej za… więcej bałaganu.

Nie oznacza to oczywiście, że AI jest bezużyteczna lub szkodliwa sama w sobie. Chodzi o sposób jej implementacji i nierealistyczne oczekiwania.

Narzędzie samo nie naprawi złej organizacji pracy.

Dla wielu programistów diagnoza Raada brzmi jak ulga. Ktoś ważny w branży powiedział głośno to, o czym oni rozmawiają przy kawie od miesięcy.

Tylko czy kierownicy wyższego szczebla też tego słuchają?